Desafie sua memória! Jogue o novo jogo N-Back no aplicativo Emotiv

Desafie sua memória! Jogue o novo jogo N-Back no aplicativo Emotiv

Smartphones Ficando Emocionais: Imagens que Lêem Mentes e Reconstruindo as Fontes Neurais

Compartilhar:

Michael Kai Petersen, Carsten Stahlhut, Arkadiusz Stopczynski, Jakob Eg Larsen e Lars Kai Hansen. DTU Informatics, Sistemas Cognitivos. Universidade Técnica da Dinamarca, Edifício 321, DK-2800 Kgs. Lyngby, Dinamarca

Resumo

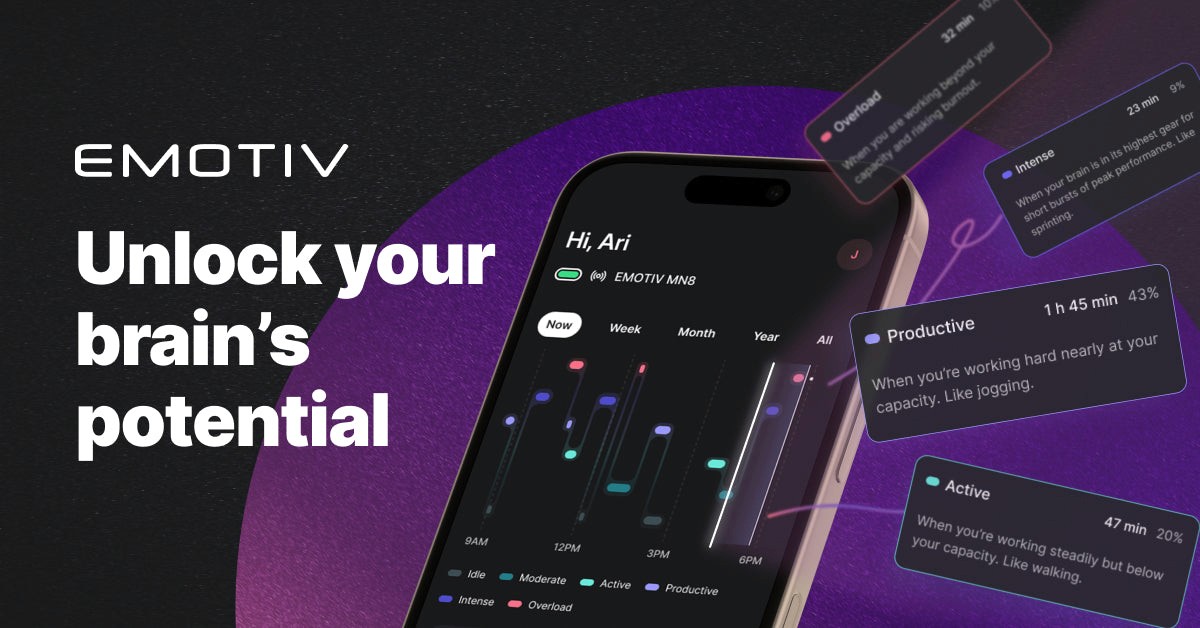

Combinar um fone de ouvido EEG sem fio com um smartphone oferece novas oportunidades para capturar dados de imagem cerebral que refletem nosso comportamento social cotidiano em um contexto móvel. No entanto, processar os dados em um dispositivo portátil requererá novas abordagens para analisar e interpretar padrões significativos, a fim de torná-los disponíveis para interação em tempo real. Aplicando uma abordagem Bayesiana para reconstruir as fontes neurais, demonstramos a capacidade de distinguir entre respostas emocionais refletidas em diferentes potenciais do couro cabeludo ao visualizar imagens agradáveis e desagradáveis em comparação ao conteúdo neutro. Renderizar as ativações em um modelo cerebral 3D em um smartphone pode não apenas facilitar a diferenciação das respostas emocionais, mas também proporcionar uma interface intuitiva para interação baseada em toque, permitindo tanto modelar o estado mental dos usuários quanto fornecer uma base para novas aplicações de biofeedback.Clique aqui para ler o relatório completo

Michael Kai Petersen, Carsten Stahlhut, Arkadiusz Stopczynski, Jakob Eg Larsen e Lars Kai Hansen. DTU Informatics, Sistemas Cognitivos. Universidade Técnica da Dinamarca, Edifício 321, DK-2800 Kgs. Lyngby, Dinamarca

Resumo

Combinar um fone de ouvido EEG sem fio com um smartphone oferece novas oportunidades para capturar dados de imagem cerebral que refletem nosso comportamento social cotidiano em um contexto móvel. No entanto, processar os dados em um dispositivo portátil requererá novas abordagens para analisar e interpretar padrões significativos, a fim de torná-los disponíveis para interação em tempo real. Aplicando uma abordagem Bayesiana para reconstruir as fontes neurais, demonstramos a capacidade de distinguir entre respostas emocionais refletidas em diferentes potenciais do couro cabeludo ao visualizar imagens agradáveis e desagradáveis em comparação ao conteúdo neutro. Renderizar as ativações em um modelo cerebral 3D em um smartphone pode não apenas facilitar a diferenciação das respostas emocionais, mas também proporcionar uma interface intuitiva para interação baseada em toque, permitindo tanto modelar o estado mental dos usuários quanto fornecer uma base para novas aplicações de biofeedback.Clique aqui para ler o relatório completo

Michael Kai Petersen, Carsten Stahlhut, Arkadiusz Stopczynski, Jakob Eg Larsen e Lars Kai Hansen. DTU Informatics, Sistemas Cognitivos. Universidade Técnica da Dinamarca, Edifício 321, DK-2800 Kgs. Lyngby, Dinamarca

Resumo

Combinar um fone de ouvido EEG sem fio com um smartphone oferece novas oportunidades para capturar dados de imagem cerebral que refletem nosso comportamento social cotidiano em um contexto móvel. No entanto, processar os dados em um dispositivo portátil requererá novas abordagens para analisar e interpretar padrões significativos, a fim de torná-los disponíveis para interação em tempo real. Aplicando uma abordagem Bayesiana para reconstruir as fontes neurais, demonstramos a capacidade de distinguir entre respostas emocionais refletidas em diferentes potenciais do couro cabeludo ao visualizar imagens agradáveis e desagradáveis em comparação ao conteúdo neutro. Renderizar as ativações em um modelo cerebral 3D em um smartphone pode não apenas facilitar a diferenciação das respostas emocionais, mas também proporcionar uma interface intuitiva para interação baseada em toque, permitindo tanto modelar o estado mental dos usuários quanto fornecer uma base para novas aplicações de biofeedback.Clique aqui para ler o relatório completo